三花快讯 · 2024, 5月13日

xLSTM:LSTM 老树开花

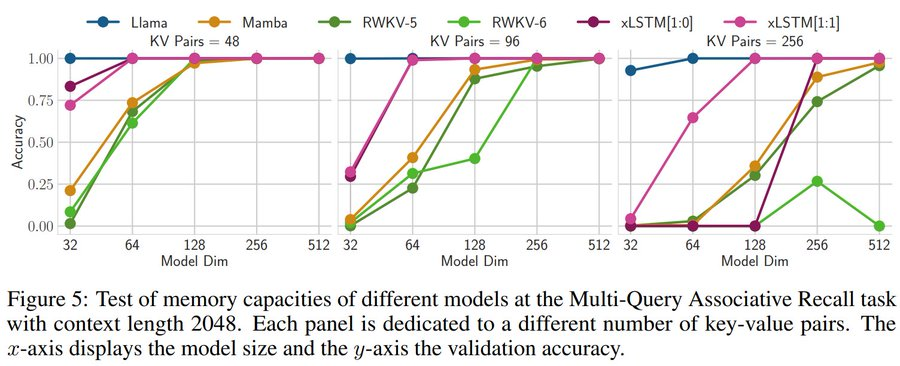

LSTM 扩展到数十亿参数,并利用现代 LLMs 的最新技术,同时解决LSTM已知的局限性时,在性能和扩展性方面与最先进的 Transformer 和状态空间模型(State Space Models)相比表现良好。

LSTM(Long Short-Term Memory,长短期记忆)历史悠久,随着Transformer技术的出现,其核心的可并行自注意力机制使得LSTM在规模化方面逐渐落后。

LSTM 扩展到数十亿参数,并利用现代 LLMs 的最新技术,同时解决LSTM已知的局限性时,在性能和扩展性方面与最先进的 Transformer 和状态空间模型(State Space Models)相比表现良好。

商业转载请联系三花微信公众号获得授权,非商业转载请注明本文出处及文章链接,您可以自由地在任何媒体以任何形式复制和分发作品,也可以修改和创作,但是分发衍生作品时必须采用相同的许可协议。

本文采用 CC BY-NC-SA 4.0 - 非商业性使用 - 相同方式共享 4.0 国际 进行许可。